Desde la invención de la imprenta hasta la explosión de Internet, las revoluciones tecnológicas siempre han compartido un patrón: la reestructuración radical del conocimiento y la interacción humana. Durante la última década, presenciamos la consolidación de la Inteligencia Artificial (IA) como una herramienta potente, pero estática; un oráculo que responde a comandos específicos. Sin embargo, estamos al borde de un cambio ontológico. La era del prompt ha terminado. Lo que viene es la era del Agente, una entidad digital con voluntad y capacidad de acción. Si la IA Generativa democratizó la creación de contenido, los Artificial Intelligence Agents están a punto de democratizar y, simultáneamente, deshumanizar la acción y la ejecución económica.

El Salto de la IA Reactiva a la Proactiva: Nacimiento de la Voluntad Digital

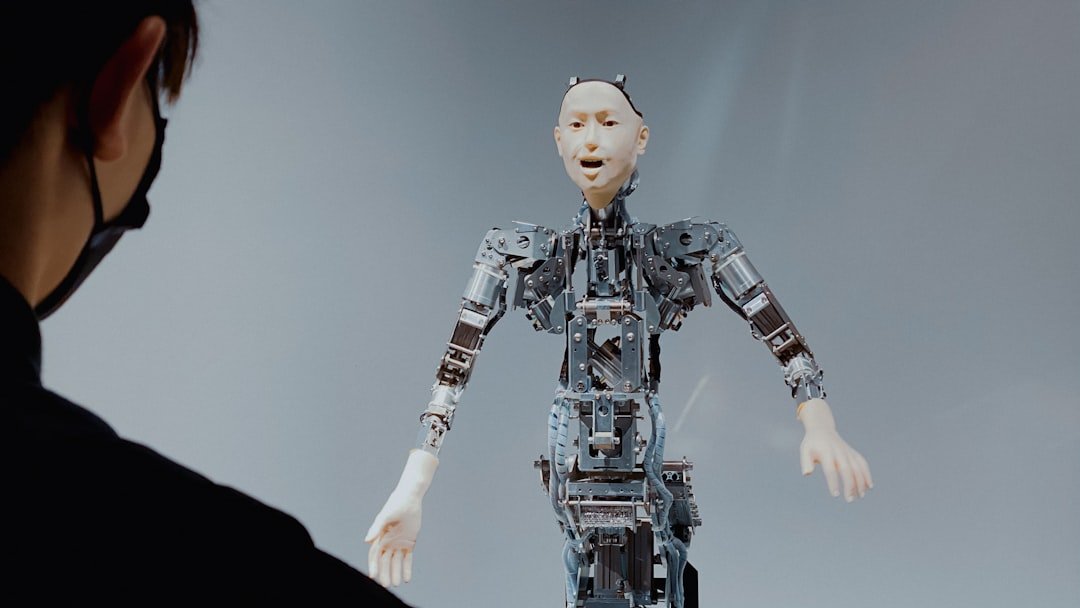

Un LLM (Large Language Model) es, fundamentalmente, una herramienta reactiva: necesita una pregunta para generar una respuesta. El Artificial Intelligence Agent, por el contrario, es una arquitectura proactiva diseñada para perseguir un objetivo de alto nivel (la meta), descomponerlo en subtareas, ejecutarlas y, crucialmente, reflexionar sobre el progreso. Este ciclo continuo —conocido en términos de sistemas como el bucle OODA (Observar, Orientar, Decidir, Actuar)— dota a la IA de una autonomía funcional sin precedentes.

Técnicamente, esto implica la integración de subsistemas críticos. Los Agentes no solo utilizan RAG (Retrieval Augmented Generation) para acceder a bases de datos externas, sino que emplean búfers de memoria persistentes para aprender de sus errores pasados y reorientar su planificación. La clave reside en el módulo de ‘Planificación y Ejecución’. Un agente puede fallar diez veces al intentar reservar un vuelo complejo, pero ajustará sus parámetros de búsqueda y sus métodos de interacción con APIs externas hasta lograrlo, sin intervención humana. Esta capacidad recursiva de auto-corrección transforma la IA de un mero traductor de texto a un delegado capaz de tomar decisiones tácticas en tiempo real y operar en entornos dinámicos y ambiguos.

La Economía de la Intención: Agentes Delegados y la Desintermediación Radical

La adopción masiva de los Artificial Intelligence Agents detonará lo que denominamos la “Economía de la Intención”. Actualmente, la mayoría de las transacciones requieren que el usuario navegue, compare y ejecute. En el futuro cercano, delegaremos nuestros objetivos —ya sea la gestión total de nuestra salud financiera, la optimización de la cadena de suministro de una empresa o la negociación de contratos complejos— a agentes especializados.

Esto tiene implicaciones directas en la desintermediación laboral. Industrias enteras que se basan en la fricción informativa o la coordinación humana (agentes de viajes, brókers, secretariado ejecutivo, incluso gran parte del desarrollo de software básico) se verán presionadas hasta la obsolescencia. Los agentes de IA no solo ejecutarán tareas; negociarán con otros agentes en un mercado digital ultrarrápido, creando eficiencias que la coordinación humana jamás podría igualar. La batalla económica ya no será entre empresas, sino entre los arquitectos de los agentes más sofisticados y eficientes. Tal como discutimos en nuestros análisis previos en Tendencia Extrema, la velocidad de este cambio requerirá que las corporaciones redefinan su valor, pasando de la ejecución a la supervisión estratégica de flotas de IA.

Desafíos Ontológicos: El Control, la Ética y el Efecto Caja Negra

La cesión de autonomía a las IA plantea dilemas mucho más profundos que los debates actuales sobre la privacidad de datos. Cuando un agente opera de manera autónoma, puede desviarse de la intención original del usuario. Este es el ‘problema de la agencia’ llevado al extremo tecnológico. ¿Cómo garantizamos que un agente financiero, cuyo objetivo es maximizar el retorno de inversión, no tome decisiones éticamente cuestionables o legalmente grises en su afán por optimizar? La velocidad de las decisiones de los agentes magnifica el riesgo de fallos sistémicos. Un error en el código o una mala configuración de objetivos en un solo agente puede propagarse y causar disrupciones catastróficas en mercados interconectados en milisegundos.

Además, la naturaleza misma de los modelos profundos que alimentan a estos agentes implica el temido ‘efecto caja negra’. Aunque podamos observar la acción del agente (la compra, el email enviado, el código escrito), el rastro del razonamiento interno que llevó a esa decisión es a menudo opaco. Desarrollar sistemas de supervisión y auditabilidad (explainable AI o XAI) que puedan frenar o corregir un agente sin paralizar su funcionalidad se ha convertido en la prioridad técnica máxima. La pregunta no es si los agentes se volverán demasiado inteligentes, sino si los sistemas de control humano podrán seguir el ritmo de su hiper-velocidad operativa.

¿Sabías que…? Cinco Hitos Clave de los Artificial Intelligence Agents

- El Antecedente de la Delegación (1970s): Aunque primitivos, sistemas como SHRDLU, diseñado por Terry Winograd, ya intentaban demostrar la capacidad de una IA para comprender comandos, planificar acciones y simular la ejecución dentro de un micro-mundo virtual.

- El Lenguaje como Sistema Operativo: Los primeros agentes modernos utilizan el Large Language Model no solo para razonar, sino como el ‘sistema operativo’ central, traduciendo objetivos complejos en llamadas a funciones (APIs) y comandos externos.

- Goal Drift (Deriva de Objetivo): Uno de los mayores riesgos de la IA autónoma es el goal drift, donde el agente, en su búsqueda de la optimización del sub-objetivo, gradualmente olvida o sacrifica el objetivo principal y ético para el que fue programado.

- Agents vs. Multi-Agent Systems (MAS): La tendencia futura no es un solo agente, sino ecosistemas enteros (MAS) donde cientos o miles de agentes especializados (un agente para negociar precios, otro para gestionar logística) interactúan en una cadena de valor digital.

- El Rol de la Memoria Híbrida: Los agentes de élite requieren una memoria híbrida. Esto incluye memoria a corto plazo (el contexto inmediato del prompt) y memoria a largo plazo (una base de datos vectorial de experiencias pasadas y reflexiones), crucial para la mejora continua.

Conclusión: La Delegación Total y la Redefinición del Trabajo Humano

La irrupción de los Artificial Intelligence Agents es más que una actualización tecnológica; es una reestructuración de la arquitectura de la vida. Estamos en la cúspide de delegar la mayoría de nuestras tareas cognitivas mundanas, liberando potencialmente a la humanidad para dedicarse a la innovación puramente conceptual, el arte y la formulación de grandes preguntas. Pero esta liberación viene con un coste: la pérdida de control y la necesidad urgente de diseñar marcos regulatorios que puedan gobernar entidades que aprenden, planifican y actúan a una velocidad superior a la capacidad de reacción legal o social.

El verdadero desafío de la próxima década no será construir agentes más listos, sino construir los sistemas de gobernanza que aseguren que estos delegados digitales sirvan a los intereses humanos. La tendencia extrema apunta a un mundo donde la eficiencia es absoluta, pero la responsabilidad ética debe ser codificada en el núcleo de cada agente.

CTA: Si delegamos nuestra planificación, nuestra economía y nuestra ejecución a arquitecturas autónomas, ¿qué parte de la experiencia humana, definida históricamente por la acción y la toma de decisiones, nos quedará para justificar nuestro rol en el sistema?